Nice project about a lamp called “Pinokio” with personality that is curious, looks at you and doesn’t like to be switched off – inspired by the famous Pixar lamp. Created by Shanshan Zhou, Adam Ben-Dror and Joss Doggett. The lamp is driven by Arduino components and programmed in Processing. Visit the project page or the technical build log.

Page 6 of 8

Microsoft’s Vision of HCI

Although Microsoft has a reputation for building suboptimal user interfaces, its research department actually has several world-class interaction design researchers (like Buxton, Hinckley, Wilson, Benko). There is no big human-computer interaction conference, be it CHI, SIGGRAPH, UIST or ITS, without several papers and keynote speakers from Microsoft Research. Recently, Microsoft has released several videos about the future in human-computer interaction, and these video actually assemble many quite recent research findings which are adopted almost one-to-one.

Here’s another one:

Some of the research concepts you see in the videos are:

- Proxemic interaction (cf. Saul Greenberg, Till Ballendat et al.)

- See-through displays

- Multitouch and animation (cf. Takeo Igarashi)

- Telepresence

- Back-of-the-device interaction (e.g. Baudisch)

- In-air gesture control

- Interaction with and between multiple devices

- Tangible Interaction (cf. Hiroshi Ishii et al.)

Windows 8 Critique by UI Expert Nielson

Jakob Nielson is a well known and highly regarded expert in the world of interface/interaction design and human-computer interaction in general. He wrote a critique on Windows 8 shortly after its release which caused a lot of controversy in the net (try Google with “Nielson Windows 8”). Nielson heavily criticizes the way that Windows 8 tries to fuse desktop and mobile UI.

What’s interesting is that Nielson did empirical user studies with 12 experienced PC users. The findings that I find most relevant are these three:

- The double desktop (one traditional, one with big touchable tiles) is confusing since one has to switch between two worlds that work very differently (inconsistency).

- The flat Metro style, while visually pleasing, makes it hard to distinguish regular text from clickable links.

- Some of the new gestures that e.g. require the user to swipe from the outside of the touchpad into it are highly error-prone.

I recently got my own Windows 8 laptop and could experience “live” some of these concerns. Even now, I find it difficult to know whether I’m in the Metro world or in the traditional desktop world because with ALT+TAB you switch between all applications (of both worlds). Gesture interaction is a pain. Of course, Microsoft has the problem that it tries to introduce new interaction techniques for a huge range of actual hardware devices. That may be one reason why the resulting experience does not feel as optimized as in Apple products.

Nielson’s own summary is this:

Hidden features, reduced discoverability, cognitive overhead from dual environments, and reduced power from a single-window UI and low information density. Too bad.

If you want a balanced picture, read some of the counter arguments on the net. I do not link up any because I haven’t found anything substantial yet.

Codecademy vs. Khan Academy: Interaktiv Programmieren lernen

Eine weitere Online-Plattform, um Programmieren zu lernen, teilweise sogar auf Deutsch, ist Codecademy. Bislang sind folgende Sprachen im Angebot: JavaScript, Python, HTML/CSS und Ruby.

Es gibt Lektionen und man programmiert online in einem Editor-Teilfenster und kann anschließend mit eine RUN-Button das Programm ausführen und bekommt Feedback. Im Screenshot sieht man in der linken Spalte die Texterklärung und jeweils nächste Übungsanweisung. Rechts ist der Editor und darunter die Konsolenausgabe.

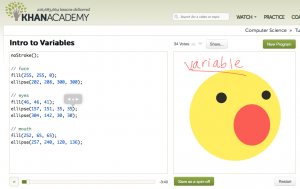

Etwas ähnliches bietet Khan-Academy (Bereich Computer Science), allerdings nur für JavaScript und nur auf Englisch. Hauptunterschied zu Codecademy ist, dass die Übungen per Audio vermittelt werden (Sprecherin: Vi Hart). Im Screenshot sieht man links den Code-Editor, rechts ist die (meist grafische) Ausgabe. Unter dem Code ist der PLAY-Button für den Audio-Kommentar.

Ohne mich viel mit den beiden Plattformen beschäftigt zu haben, wirkt die Khan-Academy didaktisch etwas stringenter, bietet dafür aber eine spezielle Programmiersprache, ist also vielleicht für Programmier-Einsteiger am besten geeignet.

Codecademy richtet sich eher an Leute, die sich schnell in eine spezielle Sprache einarbeiten wollen.

Facial Expression Replication in Realtime

The FaceShift software manages to use the depth image of the Kinect for a realtime replication of the speaker’s facial expression on an avatar’s face. Awesome. Look at the video to see how fast the approach is – hardly any visible latency between original motion and avatar and really subtle facial motions are translated to the virtual character. The software was developed by researchers from EPFL Lausanne, a research center with an excellent reputation, especially in the area of computer graphics. The software is envisioned to be used in video conferencing and online gaming contexts, to allow a virtual face-to-face situation while speaking.

Khan-Academy-Videos: Informatik / deutsche Versionen

Ich habe in einem früheren Blog-Eintrag schon kurz von der Khan-Academy berichtet. Dort wird auf ca. 3000 Videos (je 10 Min.) alles mögliche erklärt, von Bruchrechnen bis Astrophysik. Eine gigantische “Schule”, die kostenlos ist, wunderbar erklärt und so selbstbestimmtes Lernen und Entdecken weltweit ermöglicht.

Informatik/Programmieren

Im Bereich Informatik wird mit Hilfe eines interaktiven Programmierbildschirms und Audio-Begleitung das Programmieren geübt (Programmiersprache ist JavaScript mit einer Library, die dem ganzen einen Processing-Flavor gibt): Khan Academy Computer Science. Die Sprecherin ist Vi Hart und es ist alles sehr Grafikorientiert und natürlich auch humorvoll. Leider gibt es hier keine deutsche Übersetzung.

Deutsche Versionen / deutsche Untertitel

Einige der Videos gibt es auch auf Deutsch, leider nur sehr wenige und mit teils durchwachsener Qualität. Hier ist der deutsche YouTube-Kanal. Schauen Sie mal rein, wenn Sie kein Englisch können. Hier gibt es immerhin schon Themen wie Trigonometrie und Algebra. Auf den originalen Khan-Videos kann man teilweise deutsche Untertitel aktivieren. Ich übersetze derzeit einige der Statistik-Videos.

In Presse und Buch

Sehr lesenwert ist auch ein Artikel des Forbes-Magazins, das sich normalerweise nur mit Billionären und ihren Firmen beschäftigt: One Man, One Computer, 10 Million Students: How Khan Academy Is Reinventing Education.

Das Buch, in dem Firmengründer Salman Khan seine Vision der Schule der Zukunft beschreibt, ist ebenfalls kürzlich erschienen: The One World Schoolhouse. Die deutsche Übersetzung “Die Khan-Academy: Die Revolution für die Schule von morgen” ist für Februar 2013 angekündigt. Hier ein Auszug von der Amazon.de-Seite:

Salman Khans weit reichende Vision lautet: »Kostenlose, erstklassige Bildung für jedermann an jedem Ort der Welt.« Sein leidenschaftlicher Appell trifft den Kern: »Es geht nicht nur um Prüfungsergebnisse. Es geht um das Leben der Menschen. Es geht um ausgeschöpfte oder verschwendete Potenziale, um gewährte oder versagte Würde.«

(Amazon.de, 03.11.2012)

Online Python Tutor

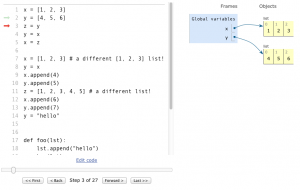

Philip Guo (currently at Google) created a wonderful web-based tool to visualize the execution of an arbitrary Python program. An excellent way to learn about variable bindings, function calls etc.

It is free and easy (well, instant) to use. Try it!

Here’s the link: http://www.pythontutor.com

The Art of Web Design

Nice overview of how web design/technology has changed over the past 20 years, from pure HTML via HTML+CSS to HTML5.

Permanent Subjective Foto Stream

The company “OMG Life” released a camera called “Autographer” that you can wear around your neck and makes a stream of pictures throughout the day, based on sensor readings. The sensors (location, acceleration, light, temperature ..) are used to make the decision whether a moment is “interesting”.

This idea sounds familiar from the MyLifeBits project at Microsoft Research around 2002. The researchers developed a device called SenseCam and published their heuristics to detect interesting moments based on rules (e.g. a drastic change in light may indicate that the user enters/leaves the house). The MyLifeBits project goes further back to 1945 when Vannevar Bush published his vision of the Memex computer system that would store all an individual’s books, notes and other documents and thus extend one memory. Your can read his article “As We May Think” online (July 1945 Atlantic Magazine).

Also see the Autographer homepage and the SenseCam project page.

References

Gemmel et al. (2002) MyLifeBits: Fulfilling the Memex Vision. In: Proc. of ACM Multimedia.

Neuer Fingercontroller: Leap Motion

Update: Das Gerät scheint auf dem Markt zu sein. Engadget hat am 25.5.2012 einen Hands-on-Bericht veröffentlicht (siehe Video weiter unten).

Die Firma Leap Motion entwickelt seit 4 Jahren an einem hochpräzisen Detector à la Kinect, aber viel präziser, wie aus ihrem Video hervorgeht. Microsoft’s Kinect kann zwar den Körper als “Skelett” in 3D tracken, ist aber nicht präzise genug, um Finger zu erkennen. Wenn das Gerät von Leap Motion so funktioniert wie dargestellt und tatsächlich günstiger ist als die Kinect, würde das den Sensormarkt tatsächlich revolutionieren. Für die Eingabe von Gebärdensprache z.B. ist die Kinect nicht geeignet. Mit Leap Motion wäre eine Gebärdensprach-Erkennung zumindest theoretisch möglich.

Hier das Video von Leap Motion:

Links:

Hier der Test von Engadget: